Estamos en 1971. The Rolling Stones empiezan a grabar su nuevo disco «Exile on Main Street» en Francia. Se han fugado de Inglaterra porque les persigue su agencia tributaria, como youtubers pioneros. Así que se van a la playa, y en los años 70 qué mejor sitio podrían encontrar que Cannes. Se cuenta que la grabación del disco fue un auténtico despropósito. Se la pasaban tomando drogas para «desayunar, comer y cenar», el descontrol era la norma. Cuando les apetecía tocaban; cuando no querían tocar, se iban a dormir o de juerga, o se ponían hasta arriba de alcohol o cualquier merca, preferiblemente heroína. Después de tres días de canciones de porquería, de pronto surgía una obra maestra. Puro movimiento browniano. Ni el productor Jimmy Miller se escapó de tan tremenda joda. ¿Era posible obtener cualquier cosa mínimamente decente así? Así fue como, anárquicamente, se grabaron las 18 canciones del primer álbum doble de los Stones, que como método sólo tuvo ninguno. Todo eso para desesperación de Mick Jagger que contaba “tuve que terminar de producir el disco yo mismo; no hubo otra manera, porque por allí sólo había borrachos y yonquis«. No había orden, pero surgía el concierto. Cuando a Keith Richards le preguntaron sobre ello, contestó «Me, I’m just happy to wake up and see who’s hanging around. Mick’s rock, I’m roll«. Si buscamos metáforas, si Mick Jagger es sólido no hay duda que Keith Richards es líquido.

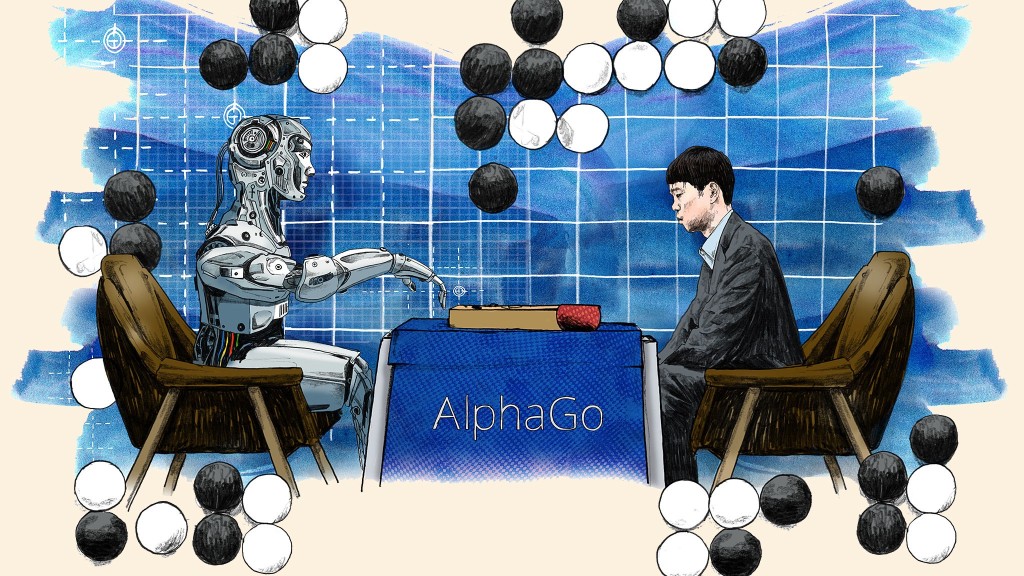

Tras la palabra “líquido” fácilmente pensamos en agua. O en la lluvia. O en el mar. A Bauman la palabra líquido le inspiraba “vida”. La vida que viviríamos todos en una sociedad moderna… líquida. En su libro del año 2000 “Modernidad líquida”, el filósofo alemán Zygmunt Bauman nos presentaba a la sociedad que aparecía en el nuevo siglo. Una sociedad donde el individuo actuaría y cambiaría más rápido y más a menudo, para fusionarse y adaptarse a otros hábitos y rutinas. Velocidad como paradigma en una permanente evolución que no podría ser ordenada, controlada o, ni siquiera, racionalizada. Paradójicamente, la liquidez se iniciaba con la modernidad que nos otorgaba la computación: en 1971 la Intel Corp diseñaba el i4004, el primer microprocesador en un chip de 4 bits, y en 1981 IBM comercializaba la primera computadora personal por 5.000 dólares, en la que podía instalar por 100 dólares un sistema operativo llamado MSDOS de una empresa desconocida: Microsoft. Mientras la computación facilitaba la construcción de orden, progreso económico y la globalización, la humanidad se desordenaba. Escribe Borges en “Fragmentos de un Evangelio Apócrifo”: “Nada se edifica sobre la piedra, todo sobre la arena, pero nuestro deber es edificar como si fuera piedra la arena...”. En la vida líquida, en la moderna sociedad líquida, individuos o instituciones no pueden mantener la forma o el rumbo por mucho tiempo. Parafraseando a Borges, en nuestra modernidad lo más sólido que podríamos construir serían castillos de arena construidos en arena.

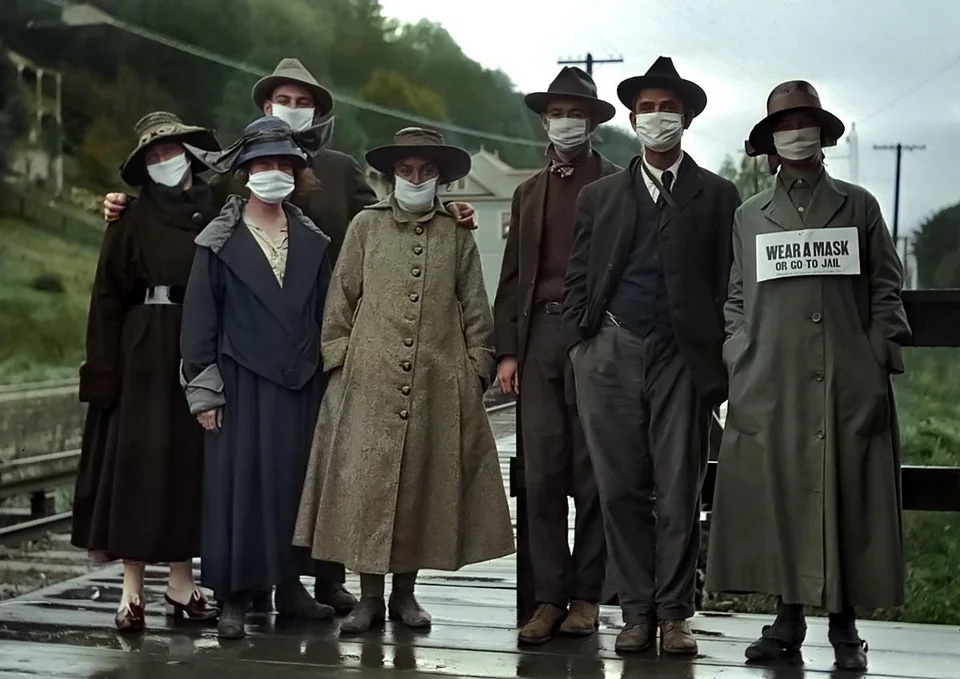

¿Es 2021 un año líquido? Eso parece. Vivir en la era del coronavirus resulta otro desafío más en nuestras vidas, ya sobradamente complejas. Seguimos estupefactos comprobando como las estructuras sociales y políticas existentes siguen sin herramientas suficientes para reconducir la situación. Paradojas de la modernidad, ante un nuevo desafío global, esta vez sanitario, los gobiernos nos proponen soluciones individuales: cuídate, protégete, sepárate, cierra. La sociedad se remodela a gran velocidad, y aún no sabemos cómo quedará tras el coronavirus. ¿Recuperar la normalidad? ¿Cuál? Sin guerra fría, con el terrorismo yihadista confinado, y sin un Donald Trump al que pegar todos los días, el coronavirus es el nuevo enemigo global. En este largo 2020, se han dado opiniones de todo tipo sobre un posible «cambio de era». incluso en este blog. Entre todos estos ensayos, destaca el artículo de Yuval Harari que publicó el Financial Times en marzo de 2020. Ahí, el autor del best seller “Sapiens” analizaba cómo quedaría la sociedad global tras superar el virus. Según Harari, habría un control mayor sobre los individuos, el Estado, a través de la inteligencia artificial y del Big Data, nos vigilaría/protegería/controlaría, justificándolo en el riesgo de una nueva cepa vírica. Un año después, en febrero de 2021, Harari regresaba al Financial Times. Harari constata el éxito “sin precedentes” de ingenieros y científicos para no haber detenido un mundo confinado y obtener vacunas en un tiempo record. Constataba, también, el fracaso de la política: sin coordinación, sin alianzas, sin planes y (como sugería un año antes) tentada de aprovechar esta oportunidad para controlar a sus votantes, ahora, digitalmente.

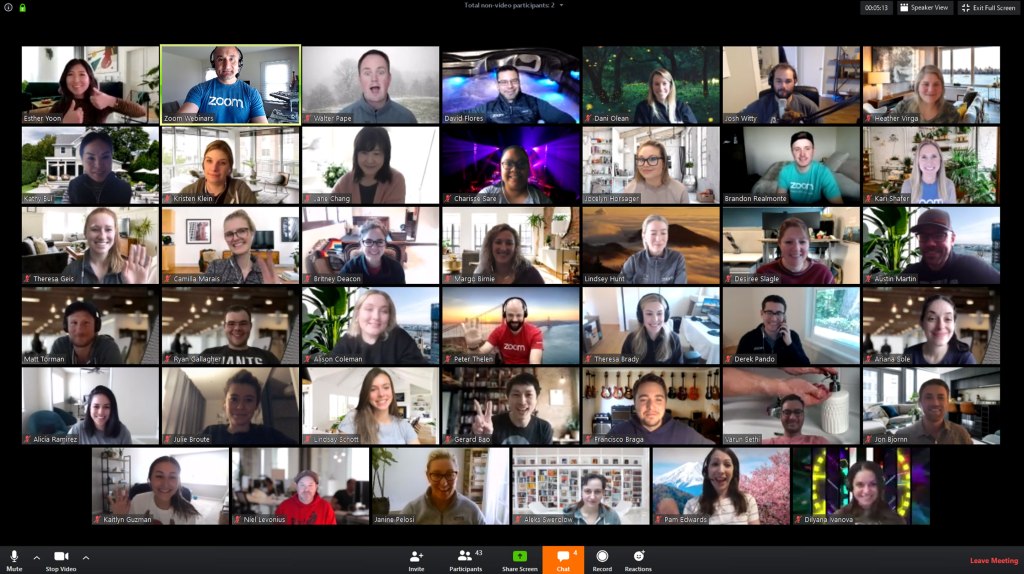

Por su parte, el filósofo coreano Byung-Chul Han residente en Berlin, escribía en marzo de 2020 sobre cómo China o Corea del Sur controlaban con éxito la pandemia. A diferencia de Harari, el Dr. Han no consideraba el control tecnológico como una posibilidad: para él ya existía. China y Corea del Sur son sociedades culturalmente muy organizadas, obedientes y con modernas tecnologías implantadas, que facilitan el control tecnológico de sus gobiernos. Además, confían más en el Estado que en Occidente, lo que permite jefaturas más autoritarias. Han, de todas formas, no justificaba ese éxito sanitario en la tecnología, sino en el civismo. A la vez, exponía la paradoja de Occidente: no aceptamos el control digital del gobierno, pero nos desnudamos en las redes sociales sin excesivo pudor. Un año después, Han escribió de nuevo sobre la pandemia y el efecto de la tecnología la sociedad: el coronavirus sería un catalizador de los males de las sociedades modernas. Zoom y el teletrabajo como reflejo del individualismo que prima no dejar de producir de la forma que sea; producir sin riesgo, antes que socializarnos, compartir, juntarnos o tocarnos con riesgo. El coreano-suizo-alemán planteaba en medio de la pandemia en “La Desaparición de los Rituales” como sin la socialización y sus formas perdemos la ultima estructura “sólida” que nos queda. Así, el distanciamiento social del otro, si bien nos protegería del contagio del virus, podría inocularlos otras patologías: “la distancia social destruye lo social”. Vivimos en permanente en comunicación pero sin comunidad. Juntos digitalmente, pero separados humanamente. Han escribe con desesperanza: “Ninguna alma habita dentro del enjambre digital”.

Con esta peste moderna, este “golpe del destino” que díria Bauman y que ha sido 2020, quedamos presos de lo que, también, Bauman denominaba «temblores existenciales«: las personas separadas de la comunidad a la que pertenecen ven debilitar su sentimiento estable de identidad, sintiéndose más vulnerables. Si algo recordaremos de 2020 es la precariedad con que vivimos el aislamiento o, incluso, la soledad. Miguel de Unamuno escribía en el «Del sentimiento trágico de la vida» que «Lo más santo de un templo es que es el lugar al que se va a llorar en común. […] No basta curar la peste, hay que saber llorarla”. Muchos hemos tenido que llorar solos la desgracia de esta peste moderna. Nos faltó el hombro del otro o de la otra donde llorar. Sin más visión que la nuestra, hoy el futuro nos parece más peligroso: lleno de dificultades, restricciones, protocolos, test, vigilancias… ¿Nuestro objetivo en la vida es realizarnos o, simplemente, que no nos pasen cosas malas? Gran signo de interrogación. 2020 se llevó cualquier ilusión de control engañosa. Si alguna lección hemos aprendido, al menos como individuos, es que ya no podemos controlar el mundo: ni siquiera nuestro mundo. Esta inseguridad nos convierte en personas menos libres, obligadas a una reinvención continua, porque nuestra vida social está en continuo cambio. Si no éramos líquidos, ya no queda otra chance. La flexibilidad sería la única habilidad válida; las fortalezas podrían resultar discapacidades; la incertidumbre sería la única certeza. Bueno, y el omnipresente Zoom, claro.

El artículo clásico de Garret Hardin «La Tragedia de los Comunes» ofrecía en 1968 una predicción del dilema entre individualismo y empresas colectivas, que seguramente resulta aplicable también frente a la pandemia. Hardin describió un dilema social donde la toma de decisiones individuales en una comunidad tenía siempre incentivo (el “free rider”). El problema se daba cuando todos actuaban egocéntricamente y de la misma manera, sin preocuparse por el impacto acumulativo en la sociedad. Ante la falta de cooperación, «los bienes comunes» se destruyen. La disyuntiva es: ¿hasta dónde el aislarse, el cuidarse, sería la solución, o hasta dónde hay que arriesgarse para socializar, para integrarse o colaborar? El problema supera la escala individual, y se enmarca en la escala colectiva de la vida. El filósofo Leiser Madanes, profesor de la Universidad de San Andrés de Buenos Aires, escribe en su corto ensayo “La Peste” sobre las plagas que ha vivido la historia de la humanidad. Para Madanes las pandemias tienden a romper el vínculo social, porque el otro -portador del contagio- nos resulta el enemigo. Miedo al otro. ¿hasta dónde el miedo nos protege y hasta dónde nos desarticula? Tras este año 2020 tan líquido, precario, vacío e incierto, no sabemos bien qué mundo viene. El futuro no nos promete rosas; hoy nos promete espinas. El mundo de nuestra cabeza tiene orden y reglas. El mundo que trastocó el coronavirus no se regirá por las reglas sino por los acuerdos, para que las reglas estén -de alguna forma- decididas por nosotros y no nos sean impuestas desde afuera. Habrá que aprovechar la tecnología, escuchar al miedo, cuidarse y buscar a los demás para ser más fuertes. No todos somos los Rolling Stones.